中科院联合清华北大构建新型类脑网络

2024年08月19日 15:18 发布者:eechina

中国科学院自动化研究所携手清华大学、北京大学等顶尖学府,共同宣布了一项重大科研成果:成功构建了基于“内生复杂性”的新型类脑网络。这一突破性进展不仅为AI模型的优化与性能提升提供了全新的解决方案,也为构筑AI与神经科学之间的桥梁奠定了坚实的基础。据中国科学院自动化研究所消息,该研究团队由李国齐、徐波等科学家领衔,借鉴了大脑神经元复杂动力学特性,创新性地提出了“基于内生复杂性”的类脑神经元模型构建方法。该方法有效改善了传统AI模型通过向外拓展规模导致的计算资源消耗问题,为有效利用神经科学发展AI开辟了新路径。相关研究成果已在线发表于国际顶级期刊《自然·计算科学》(Nature Computational Science)。

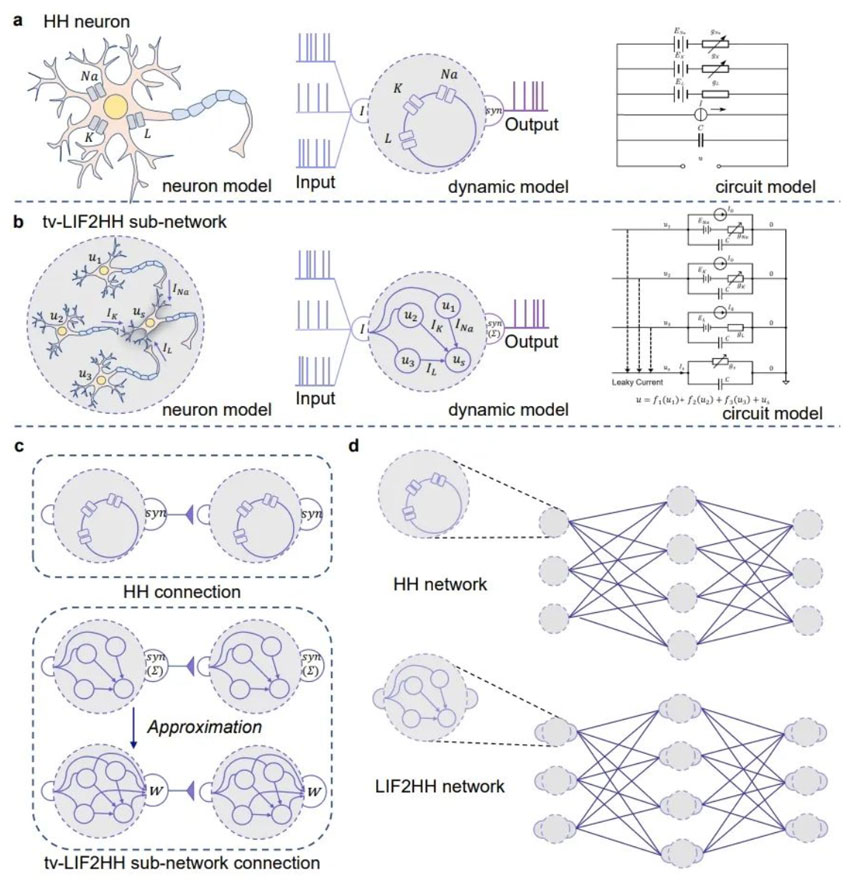

研究团队首先展示了脉冲神经网络神经元LIF(Leaky Integrate and Fire)模型和HH(Hodgkin-Huxley)模型在动力学特性上的等效性,并进一步从理论上证明了HH神经元可以与四个具有特定连接结构的时变参数LIF神经元(tv-LIF)在动力学特性上实现等效。基于这一发现,团队通过设计微架构提升计算单元的内生复杂性,使得HH网络模型能够模拟更大规模LIF网络模型的动力学特性,从而在更小的网络架构上实现相似的计算功能。

为了进一步简化模型并验证其有效性,研究团队将由四个tv-LIF神经元构建的“HH模型”(tv-LIF2HH)简化为s-LIF2HH模型,并通过仿真实验验证了这种简化模型在捕捉复杂动力学行为方面的卓越性能。实验结果表明,HH网络模型和s-LIF2HH网络模型在表示能力和鲁棒性上均展现出相似的性能,验证了内生复杂性模型在处理复杂任务时的有效性和可靠性。尤为重要的是,HH网络模型在计算资源消耗上更为高效,显著减少了内存和计算时间的使用,从而提高了整体的运算效率。

这一研究成果为将神经科学的复杂动力学特性融入AI领域提供了新方法和理论支持,为实际应用中的AI模型优化和性能提升提供了可行的解决方案。研究团队通过信息瓶颈理论对上述研究结果进行了深入解释,为未来的研究指明了方向。

目前,研究团队已着手开展对更大规模HH网络,以及具备更大内生复杂性的多分支多房室神经元的研究,旨在进一步提升大模型的计算效率与任务处理能力,推动研究成果在实际应用场景中的快速落地。这一系列工作不仅有望推动AI技术的革新,也将为神经科学领域的研究带来新的启示。