ameya360:如何减少机器学习的碳足迹

2022年09月14日 15:49 发布者:Ameya360

根据去年在IEEESpectrum上发布的《深度学习受益递减》一文中提到,随着机器学习的发展,到了2025年,最强的深度学习系统在ImageNet数据集中进行物体识别时,错误率最高只有5%。但训练这样一个系统所需要的算力和能耗都是庞大的,更糟糕的是,其排放的二氧化碳将是纽约市一整个月的排放量。 机器学习的碳排放可以被分为两种,一种是运营排放,也就是数据中心在运行机器学习硬件中产生的碳排放;第二种是整个生命周期内的排放,不仅包含运营排放,还包含了各个环节的碳排放,比如芯片制造、数据中心建造等等。考虑到后者涉及更加复杂的研究,所以大部分碳足迹的研究都集中在运营排放上。

机器学习的碳排放可以被分为两种,一种是运营排放,也就是数据中心在运行机器学习硬件中产生的碳排放;第二种是整个生命周期内的排放,不仅包含运营排放,还包含了各个环节的碳排放,比如芯片制造、数据中心建造等等。考虑到后者涉及更加复杂的研究,所以大部分碳足迹的研究都集中在运营排放上。至于如何记录碳排放,这也很简单,只需要将训练/推理的时长x处理器数量x每个处理器的平均功耗xPUEx每千瓦时的二氧化碳排放即可。除了最后一项参数需要从数据中心那获取外,其他的数据基本都是公开,或取决于机器学习研究者自己的选择。

如何减少机器学习的碳足迹

图灵奖得主、谷歌杰出工程师DavidPatterson教授对现有的机器学习的研究和工作提出了以下几点建议。首先,从模型开始着手,机器学习研究者需要继续开发效率更高的模型,比如谷歌去年发布的GLaM通用稀疏语言模型,相较GPT-3,它多出了7倍的参数,在自然语言推理等任务上都要优于GPT-3。但同样重要的是它的能耗和碳足迹指标,根据谷歌公布的数据,与使用V100的GPT-3相比,使用TPUv4的GLaM二氧化碳排放减少了14倍,可见模型对于碳足迹的影响。其次,在发布新模型的时候,他建议也把能耗和碳足迹这样的数据公开,这样有助于促进机器学习模型在质量上的良性竞争。

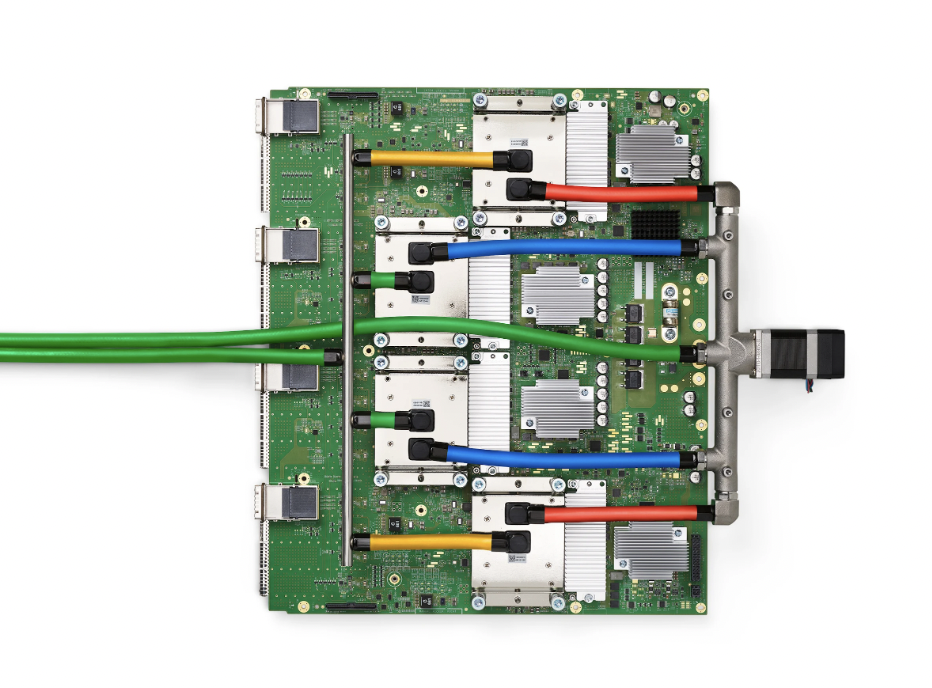

接着是硬件,他指出我们需要像TPUv4或者A100GPU等,这类机器学习能效比更高的硬件。其实这一点反倒是最不需要担心的,这几乎是每个初创AI芯片公司都在尝试的做法,即便在峰值上不敌这些硬件,也绝对会在能效比上尽可能做大极致。

还有就是常见的能效衡量指标PUE,大型机器学习负载往往要在数据中心上运行,而要让数据中心的PUE接近1并不是一件简单的事。根据UptimeInstitute的统计,各家厂商旗下最大数据中心的年度PUE为1.57,就连我国工信部印发的《新型数据中心发展三年行动计划(2021-2023)》中提出的最终目标也只是将新建大型数据中心PUE降低至1.3以下。但好在新建的数据中心往往都不会只满足于这个目标,而是往1.1乃至1.06这样的指标推进。

可这个指标并不是一个死数据,随着负载和用量的变动,PUE是在持续波动的,不少数据中心仅仅在建成时发布了能效指标,之后就再未公布过任何数据了。在这块做得最好的也还是谷歌,谷歌每年都会发布年度能效报告,将各个数据中心每个季度的PUE公布出来。

不过仅仅只有极低的PUE只能体现出高能耗比,DavidPatterson教授认为还必须一并公布每个地区数据中心的清洁能源占比。比如阿里巴巴首次发布的《2022阿里巴巴环境、社会和治理报告》中就提到了2021年,阿里巴巴在中国企业可再生能源购买者中排名第一,2022财年阿里云21.6%的电力来自清洁能源。

在双碳目标的提出下,我国其实已经落实到了机器学习的硬件上,但在软件和碳足迹透明度这方面还有可以改善的空间。机器学习要想做到消耗更低的算力来实现更优的效果,就必须从各个环节做到节能减排。